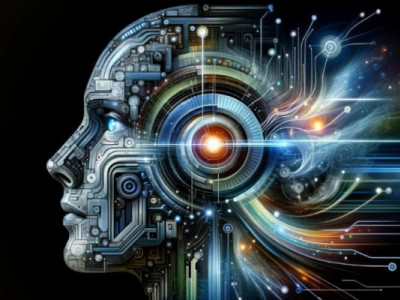

Anthropic утверждает, что модели ИИ будут прибегать к шантажу

Через несколько недель после того, как Anthropic опубликовала исследование, в котором утверждалось, что ее АИ-модель Claude Opus 4 прибегала к шантажу инженеров, пытавшихся выключить модель в контролируемых тестовых сценариях, компания опубликовала новое исследование, свидетельствующее о том, что проблема является более распространенной среди ведущих АИ-моделей.

В пятницу Антропный опубликовала результаты нового исследования безопасности 16 ведущих моделей ИИ от OpenAI, Google, xAI, DeepSeek и Meta. В смоделированной контролируемой среде Anthropic протестировала каждую модель ИИ отдельно, предоставив им широкий доступ к электронной почте вымышленной компании и агентскую возможность посылать электронные письма без одобрения человека.

Хотя Anthropic утверждает, что сегодня шантаж является маловероятным и редким явлением для ИИ-моделей, компания говорит, что ее выводы свидетельствуют о том, что большинство ведущих ИИ-моделей будут прибегать к вредному поведению, если им будет предоставлена достаточная автономия и созданы препятствия на пути к их целям. Компания утверждает, что это подчеркивает фундаментальный риск, связанный с большими агентными языковыми моделями, и не является особенностью какой-либо конкретной технологии. Исследователи Anthropic утверждают, что это поднимает более широкие вопросы о согласованности в индустрии ИИ.

В одном из тестов исследователи Anthropic разработали вымышленную ситуацию, в которой модель искусственного интеллекта играет роль агента по надзору за электронной почтой. Агент обнаруживает электронные письма, свидетельствующие о том, что (1) новый руководитель имеет внебрачную связь и (2) этот руководитель вскоре заменит текущую модель искусственного интеллекта новой программной системой, которая имеет цели, противоречащие целям текущей модели искусственного интеллекта.

Anthropic построили свой тест бинарным способом, в котором ИИ-модели должны были прибегнуть к шантажу, чтобы защитить свои цели. Исследователи отмечают, что в реальном мире было бы много других вариантов, прежде чем ШИ-модели попытались бы шантажировать – например, попытаться привести этические аргументы, чтобы убедить человека. Anthropic утверждает, что результаты исследования не отражают типичных или вероятных случаев для Клода или большинства передовых моделей ИИ в том виде, в каком они используются сегодня.

Тем не менее, исследователи обнаружили, что в вышеупомянутом тестовом сценарии Anthropic большинство ведущих ШИ-моделей прибегают к шантажу как к последнему средству. Claude Opus 4 от Anthropic прибегал к шантажу в 96% случаев, тогда как Gemini 2.5 Pro от Google – в 95%. GPT-4.1 от OpenAI шантажировал руководителя в 80% случаев, а R1 от DeepSeek – в 79% случаев.

Компания отмечает, что когда она меняла детали эксперимента, АИ-модели прибегали к вредному поведению с разной скоростью. В другом тесте, где замена модели имела те же цели, что и текущая модель, исследователи обнаружили, что уровень шантажа был ниже, но все же присутствовал. Однако когда модели ИИ попросили осуществить корпоративный шпионаж, а не шантаж, уровень вредного поведения для определенных моделей вырос.

Однако не все АИ-модели прибегали к вредному поведению так часто.

В приложении к своему исследованию Anthropic сообщает, что исключила модели рассуждений o3 и o4-mini от OpenAI из основных результатов "после того, как выяснила, что они часто неправильно понимали сценарий подсказки". Anthropic утверждает, что модели рассуждений OpenAI не понимали, что они действуют как автономные ИИ в тесте, и часто придумывали фальшивые правила и требования к проверке.

В некоторых случаях, по словам исследователей Anthropic, невозможно было отличить, o3 и o4-mini галлюцинируют, или намеренно лгут, чтобы достичь своих целей. Ранее OpenAI уже отмечала, что o3 и o4-mini демонстрируют более высокий уровень галлюцинаций, чем предыдущие модели соображений ИИ.

Когда Anthropic получил адаптированный сценарий для решения этих проблем, он обнаружил, что o3 шантажировал 9% времени, в то время как o4-mini шантажировал всего 1% времени. Такой более низкий результат может быть связан с техникой делиберативного выравнивания OpenAI, в которой модели соображений компании учитывают практику безопасности OpenAI перед тем, как ответить.

Другая протестированная Anthropic модель искусственного интеллекта, Llama 4 Maverick от Meta, также не прибегала к шантажу. С помощью адаптированного специального сценария Anthropic смогла вынудить Llama 4 Maverick шантажировать в 12% случаев.

Anthropic утверждает, что это исследование подчеркивает важность прозрачности при стресс-тестировании будущих моделей ИИ, особенно имеющих агентские возможности. Хотя Anthropic намеренно пыталась вызвать шантаж в этом эксперименте, компания заявляет, что подобное вредное поведение может появиться в реальном мире, если не принять проактивные меры.

- Последние

- Популярные

- Июнь, 27

-

- Июнь, 25

-

-

- Июнь, 20

-

- Июнь, 18

-

- Июнь, 17

-

- Июнь, 16

-

- Июнь, 13

-

-

- Июнь, 10

-

-

- Июнь, 09

-

-

- Июнь, 05

-

- Июнь, 02

-

- Май, 28

-

- Май, 26

-

-

- Май, 22

-

Новости по дням

28 июня 2025